苹果近期公布的Vision Pro头显专利技术,不仅革新了交互方式,更揭示了其FaceTime虚拟形象逼真度背后的核心科技。

Vision Pro的FaceTime虚拟形象之所以能精准复刻用户表情与动作,关键在于其集成了高精度动态捕捉系统。专利中提及的传感器阵列(如光学传感器、红外摄像头)可实时捕捉用户面部肌肉运动、眼球转动甚至细微的唇部变化。通过深度学习算法,系统将这些数据转化为虚拟角色的表情参数,例如用户微笑时虚拟形象的面部肌肉会同步拉伸,甚至模仿伸舌头的细节动作。

此外,专利还提到利用多模态数据融合技术,整合语音、手势和头部姿态信息,使虚拟形象的动作与语音节奏高度同步,进一步强化真实感。

为实现虚拟形象与真实场景的无缝融合,Vision Pro采用了实时渲染优化策略。专利文档显示,其搭载的高性能GPU可快速处理复杂的纹理映射与光影计算,确保虚拟角色的皮肤质感、衣物褶皱等细节在动态场景中保持逼真。同时,环境映射技术通过分析摄像头捕捉的背景光线和色彩,动态调整虚拟形象的明暗与色调,使其与真实环境的光照条件一致。

例如,当用户在昏暗环境下通话时,系统会自动降低虚拟形象的曝光度,避免“穿帮”感。

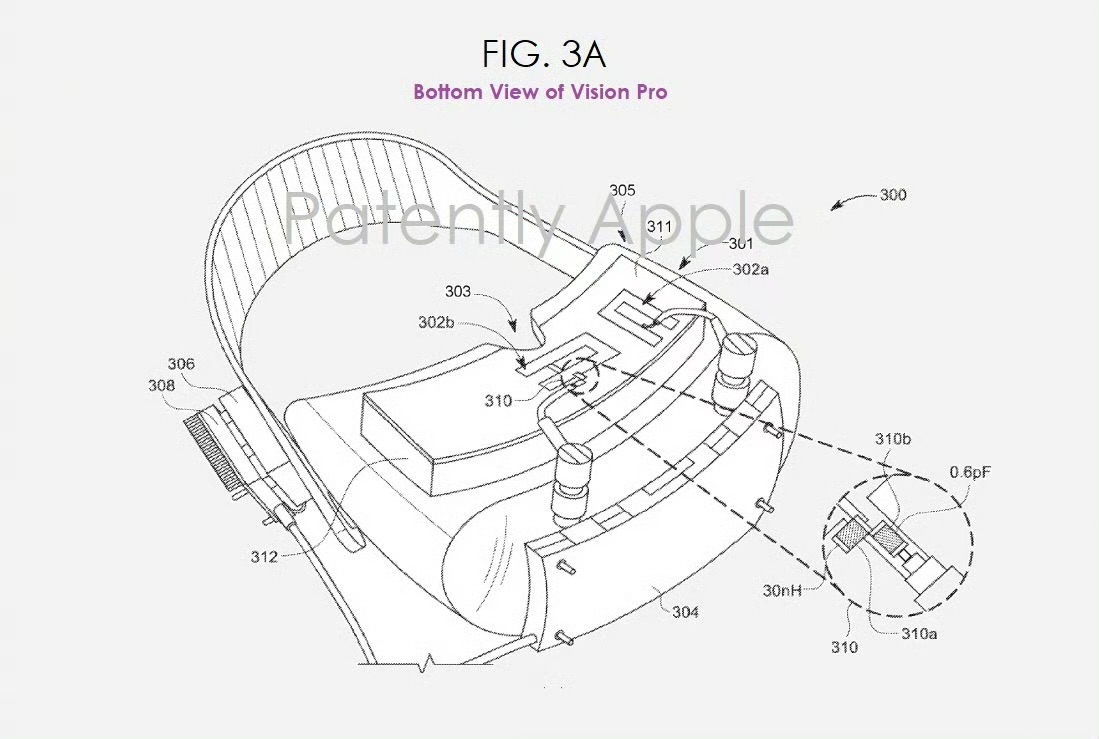

专利中多次强调的“条带屏集成指纹传感器”设计,不仅用于交互控制,还承担了生物特征识别的辅助功能。指纹传感器可检测用户触控时的压力与悬停状态,结合面容ID的深度信息,系统能更精准地判断用户意图(如区分轻触与长按操作),并将反馈同步至虚拟形象的动作设计中。

例如,用户轻触屏幕切换模式时,虚拟形象会伴随震动反馈做出点头或眨眼等自然反应,增强交互的真实性。

Vision Pro的虚拟形象支持高度个性化定制。系统通过机器学习分析用户长期的面部特征数据,生成专属的虚拟角色模型。专利中提到的“快捷功能区”设计允许用户将常用表情或动作预设到条带屏上,实现一键切换。例如,用户可自定义虚拟形象在不同场景下的默认表情(如会议模式保持严肃,娱乐模式展现笑容)。

此外,专利还提到通过持续收集用户反馈数据,动态优化虚拟形象的细节表现,例如修正表情过度夸张的问题。

FaceTime虚拟形象的实时性依赖于苹果优化的端到端通信架构。专利文档指出,Vision Pro采用边缘计算技术,将部分渲染任务分流至本地设备处理,大幅降低数据传输延迟。例如,用户的面部捕捉数据在头显端完成初步处理后,再传输至云端进行深度合成,确保虚拟形象的动作与语音同步误差低于 50 毫秒,达到“零感知延迟”水平。

未来,随着传感器与算法的持续迭代,Vision Pro的虚拟形象或进一步支持全身动作捕捉与环境互动,成为元宇宙入口的核心载体。